¿Cómo se hace una consultoría SEO paso a paso?

Una consultaría SEO tiene muchas fases, aunque en este artículo veremos aspectos fundamentales que deben tenerse en cuenta a la hora de realizar una consultaría SEO. Antes de comenzar a leer esto te recomiendo por si recién te inicias en este mundo que leas este artículo sobre 10 factores SEO claves.

Para ello utilizaremos a Reuters como medio a analizar. Ojo, el core del negocio de Reuters es ser agencia y no un medio de comunicación y por esta razón no deben prestar mucha atención a la web y optimizarla a lo mejor es contraproducente, ya que podría competir contra sus clientes… No obstante utilizaremos el caso para aprender a hacer una consultoría paso a paso.

-

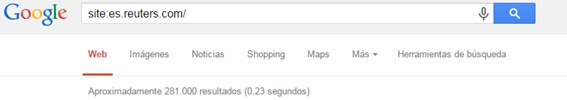

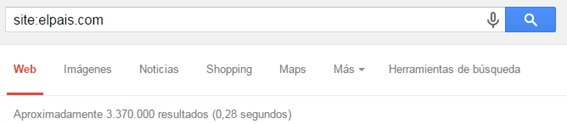

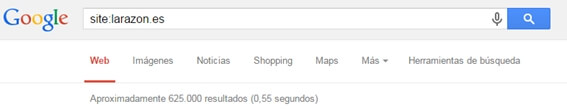

Número de páginas indexadas:

Para medir el número de páginas indexadas debemos ‘tirar un site en Google’, a través de este comando site:es.reuters.com

Vemos que el volumen de páginas indexadas es interesante. Evidentemente es mucho menor que medios de comunicación como El País, pero esto se debe al tamaño de cada uno, número de artículos generados al día, número de periodistas, etc.

Sin embargo si lo comparamos con otros medios más pequeños como La Razón por ejemplo, no existe tanta diferencia.

Por lo tanto en mi opinión (por el volumen de páginas indexadas) el producto tiene muchísimo potencial, a tal punto de poder llegar a competir con cabeceras nacionales.

-

Autoridad de Dominio y Page Rank:

Existen diferentes formas de poder medir la autoridad de un dominio. En mi opinión si utilizamos el plugin SeoMoz, vamos a poder conocer la autoridad de cualquiera de las páginas del sitio y la autoridad del dominio en general.

El DA de Reuters (autoridad de dominio) asciende a 95/100 que es altísimo, fijaros que webs como El Mundo disponen de un DA 88/100. Sin embargo el PA (autoridad de página) de El Mundo es de 90 versus 71 en Reuters. Esto se debe a que la portada de El Mundo se encuentra mucho más actualizada que la de Reuters, además de poseer muchos más enlaces.

No obstante puedes consultar el PageRank de cualquier sitio web, a través de webs como por ejemplo calcular Page Rank. Una vez introduzcas la URL web obtendrás que:

El Page Rank se utiliza para conocer la autoridad que tiene un dominio a efectos de los ojos de Google. Es un rango que va de 0 a 10, donde obtener un 0 es muy fácil y obtener un 9 es prácticamente imposible. Fundamentalmente se determina en función del número y calidad de enlaces. En cuanto a Reuters, el Page Rank está bien, el de AS.com es de 7, el de El País 8, Marca 8, El Mundo 9…

-

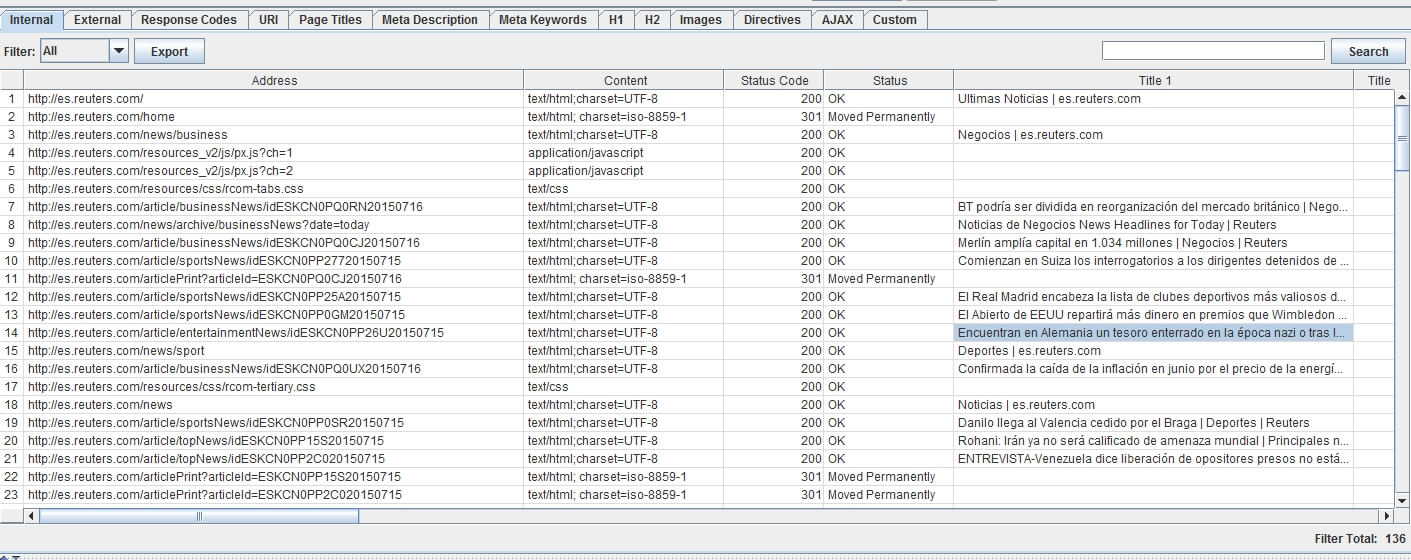

Titulares, Descripciones y Encabezamientos

A través de Screaming Frog podemos usar este bot que nos permite obtener información en tiempo real en menos de 1 minuto sobre el estado general de una página web. Rastreando datos de Reuters obtenemos sobre una muestra de 500 URLs que:

Existen algunos titles duplicados, varias descriptions duplicadas, siguen vigentes las meta keywords cuando ya hace años que se han dejado de usar. Con respecto a los H1, casi el 70% están duplicados. No existen H2.

-

Duplicidad de contenido

Los canonicals o URLs canónicas sirven para indicarle a la araña qué contenido es original. En caso de ausentarse, un contenido que cuelga de varias urls diferente será considerado contenido duplicado. Veamos un ejemplo:

Si entramos con la URL es.reuters.com y con es.reuters.com?loquesea en ambos casos carga el mismo contenido. Mismo contenido y URLs diferentes. Si es.reuters.com?loquesea se enlazará en varios sitios web rápidamente se indexaría y todo el contenido que exista en portada será duplicado.

-

Cabeceras HTPP, redireccionamientos

Algo extremadamente grave es lo que ocurre al cargar la web http://reuters.es carga exactamente el mismo contenido que http://es.reuters.com. ¿La solución? 1) Determinar que web tiene más enlaces 2) Hacer redireccionamiento de la que menos a la que más y que ese redireccionamiento sea un 301. En este caso el que más fuerza tiene es el subdominio. Por ello deberíamos hacer un 301 de http://reuters.es a http://es.reuters.com.

-

Jerarquías y Árbol de Navegación

No existe ninguna estrategia solidad en cuanto a la organización de contenido. Existen secciones como Principales Noticias, Negocio, Divisas, Deportes, Sociedad, Cotización, Vídeo… carpetizan en directorios, pero luego las URLs salen sin las carpetas. Veamos un ejemplo: La sección de Negocios se construye con http://es.reuters.com/news/business y los artículos http://es.reuters.com/article/businessNews/… No tiene ningún tipo de lógica. Lo mejor sería:

- Crear los directorios correctos es.reuters.com/negocios/title-url-friendly

- Establecer un patrón de redireccionamientos de URLs antiguas a la nueva estructura de URLs.

- Aunque lo veremos más adelante, deberían de crearse sitemaps para cada una de las secciones dando de alta así cada una de las URLs nuevas que se van generando en cada sección.

-

Búsquedas on-site:

Algunos sitios webs ofrecen la posibilidad de que los usuarios realicen búsquedas consultando sus contenidos. Lo que ocurre que esas búsquedas si se almacenan serán indexadas. Para ello todos los resultados de búsquedas deberán llevar un “noindex,follow”. En caso de dejarlo tal cual todas las búsquedas que realicen los usuarios se indexarán.

-

BackLinks:

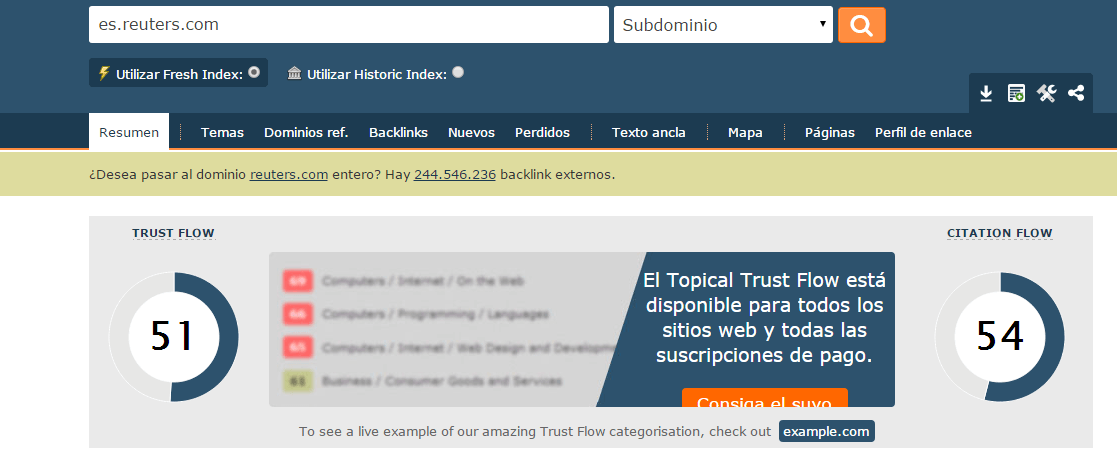

MajesticSEO, entre otras cuestiones nos permite analizar el Trust Flow, Citation Flow, la categoría web de los sitios que nos enlazan, quiénes nos enlazan, y más.

Para comenzar con este apartado definiremos el Trust Flow como el Trustworthy, es decir la veracidad del enlace, si aporta o no aporta valor para el usuario, si es un enlace natural o no artificial Además contempla el número de clicks que hacen los usuarios sobre esos enlaces…No se cómo consiguen esos datos, pero seguramente sea a través de las famosas toolbars ;)

Con respecto al Citation Flow miden el poder, la jerarquía de los sitios web que le enlazan. Mientras más enlaces tengas y más enlaces de sitios de relevancia mayor sería el citation flow. Eso si, el trust flow y el citation flow deben ir de la mano. Ninguno de los dos por separado deberían de analizarse por separado, más que nada por el análisis interesante es deivir el trust flow / citation flow, lo que arrojará un dato. Ese dato debe ser siempre estar en torno a 1 o ser mayor a 1. Si es menor, lo que ocurrirá es que la web tiene muchísimo riesgo en ser catalogada como web spam.

-

Footer Corp:

Tenemos duplicidad de contenido en todas las páginas, ya que todas cargan el mismo footer. La solución está frente a vuestros ojos, pegar el texto en formato JPG o bien cargar un iframe y que conlleve un “noindex,nofollow”.

-

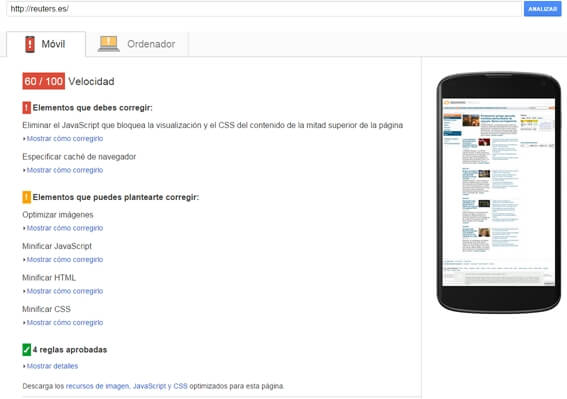

PageSpeed Isnights

Si lanzamos al araña en cuanto a velocidad, veremos que suspenso en movilidad, aprobado rasposo en móvilidad. Recomiendan eliminar el JS que bloque la visualización y el CSS del contenido… esto se refiere al mensaje de la política de cookies. Poco podremos hacer. Para mejorar los tiempos de carga deberíamos de implementar compresores GZIP y Deflate de forma conjunta, con el objeto de comprimir HTML, Texto, Imágenes, CSS. Además utilizar Minify para poder agrupar todas las peticiones a servidores terceros (JS) y agruparla en solo una llamada. Así mismo deberíamos de utilizar eTag, para facilitar los tiempos de carga de páginas estáticas. Como las portadas son dinámicas habría que implementarlas únicamente en artículos. En cuanto a movilidad, suspenso en usabilidad. No se encuentra adaptada para dispositivos móviles. Lo mejor para web de contenidos son las responsive, además de ser la que recomienda Google.

Pingback: ¿Cómo hacer una consultoría SEO? Parte 2

Pingback: ¿Cómo utilizar SEO MOZ?